Проект лаборатории поддержан грантом министерства науки и высшего образования России

Работа по Соглашению с Министерством науки и высшего образования России № 14.604.21.0207 от 26.11.2018 г. по теме «Автоматизированная система поддержки принятия врачебных решений при акушерской патологии»

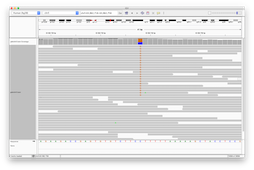

Анализ NGS

Пайплайн для анализа полных геномов либо экзомов человека

Пайплайн состоит из следующих частей:

- Контроль качества прочтений

- Выравнивание прочтений на реферненсный геном hg38

- Анализ отличчий от референсного генома

- Аннотация отличий по базам данных частот и патогенности

- Фильтрация полученных результатов

Пайплайн состоит из следующих частей:

- Контроль качества прочтений

- Выравнивание прочтений на реферненсный геном hg38

- Анализ отличчий от референсного генома

- Аннотация отличий по базам данных частот и патогенности

- Фильтрация полученных результатов

Направления

Бионформатика

Анализ биологических данных

(NGS, microarray, MS, PCR), биостатистика.

- Оценка роли микроРНК в патогенезе и диагностике эндометриоза

- Применение nmf и t-sne в задаче клеточного типирования на основе экспрессии генов

- Оценка и визуализация дифференциальной экспрессии

генов - Разработка программного комплекса для типирования генов системы HLA и KIR

- Применение метода NMF для разделения суммарных экспрессиий генов в ткани на отдельные клеточные типы

- Атлас экспрессии генов в нормальном эндометрии

Разработка ПО

Разработка масштабируемых программных комплексов, баз данных.

Математические модели

Модели сложных биологических систем и внутриклеточных процессов, анализ биологических и медицинских данных.

- Моделирование процесса деградации биополимерных скаффолодов

- Создание динамической модели структуры микробиоты с использованием методов теории графов

- Математическая модель резорбции биоматериалов адресной доставки лекарственных веществ

- Модель гидролиза алифатических полиэфиров в биологической среде при ограничении диффузии воды

Машинное обучение

Построение, обучение и внедрение технологии нейросетей, глубинного обучения, методов компьютерного зрения.

- Нейросеть для классификации патологий по данным масс-спектрометрального анализа

- Поиск визуальных паттернов, компьютерное зрение и слежение за объектами по видео на примере поиска направления взгляда новорожденных и анализ их визуальной активности

- Поиск скрытых движений на примере анализа сосательной активности недоношенных по видео

Команда

Боровиков Павел

Руководитель лаборатории, математик

Балашов Иван

Биолог, биоинформатик, биостатистик

Лагутин Вадим

Разработчик систем реального времени

Наумов Владимир

Биоинформатик, специалист по геномике человека